Вставьте URL любого GitHub PR

*На основе внутреннего тестирования

Интегрируется с

Безопасность

Вы игнорируете свой AI Code Reviewer?

Вы не одиноки. Вот что разработчики рассказали нам о традиционных AI-инструментах:

Слишком много шума

"18 комментариев на PR. Читаю максимум 2. Большинство — придирки к стилю, которые мне не важны."

— Мидл-разработчик, стартап 50 человек

Пропускает реальные проблемы

"Предлагает переименовать `e` в `error`, но полностью пропускает SQL-инъекции. Каждый. Раз."

— Сеньор-инженер, финтех

Ноль контекста

"Предлагает паттерны рефакторинга, от которых мы отказались 3 месяца назад. Не помнит наших решений."

— Техлид, компания Series B

Проблема не в AI.

Проблема в одноагентном AI.

Спекуляция vs Расследование

Посмотрите, как diffray обрабатывает реальный сценарий: изменение сигнатуры функции в вашем PR

Ответ AI:

"Это меняет тип возвращаемого значения. Убедитесь, что вызывающий код обновлён."

Расследование агента:

1. Поиск всех использований getUserData()

2. Найдено 3 места вызова с несовпадением типов

3. Проверка тестов — 2 теста нужно обновить

4. Влияние: api/users.ts:47, hooks/useUser.ts:23

В чём разница? Расследование, а не спекуляция.

Как начать

Посмотрите, как легко настроить diffray и получить первый мульти-агентный code review

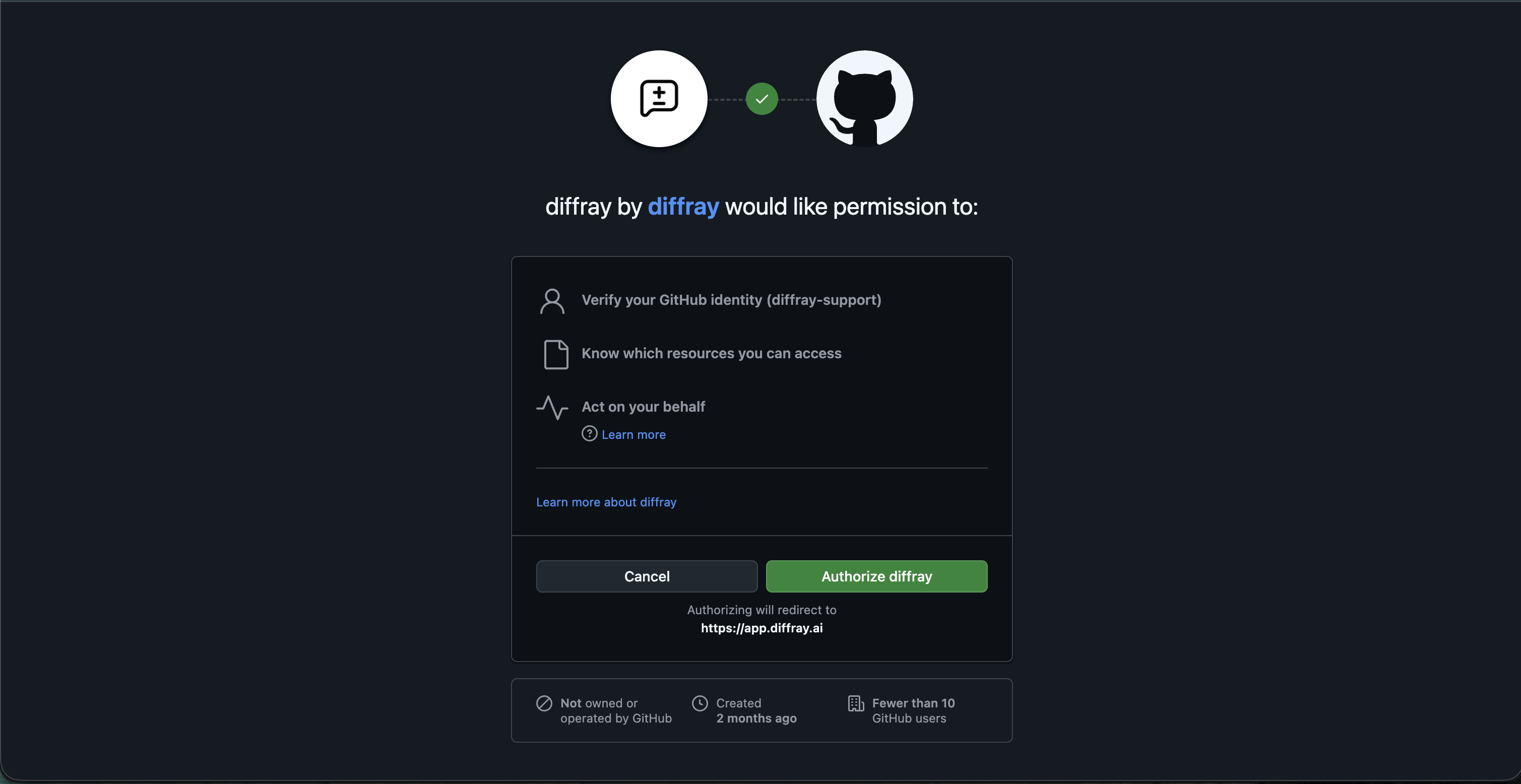

Войдите через GitHub

Подключите GitHub-аккаунт в один клик. Никакой сложной настройки — просто авторизуйтесь.

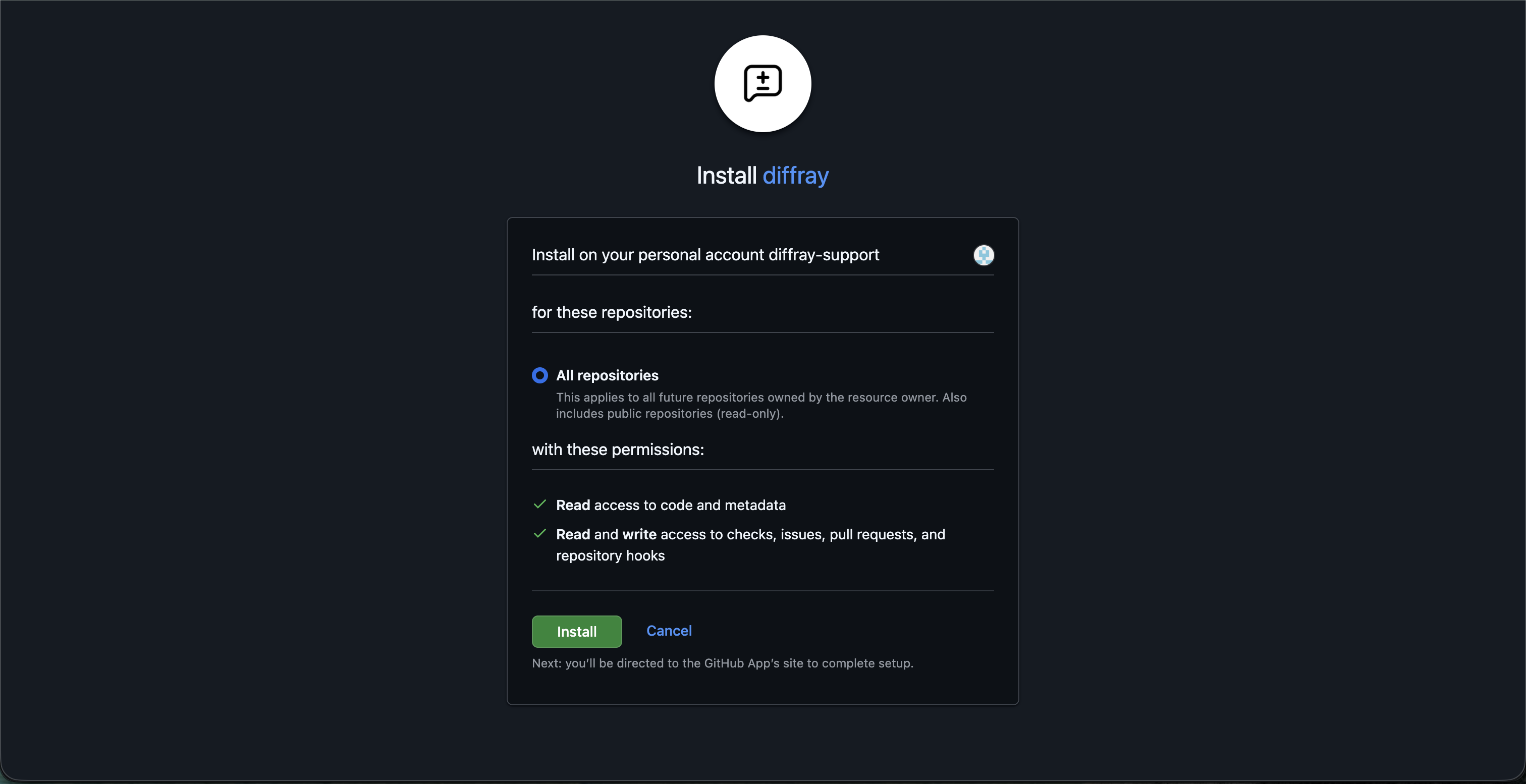

Установите GitHub App

Добавьте diffray в организацию или личные репозитории. Выбирайте, какие репо включить.

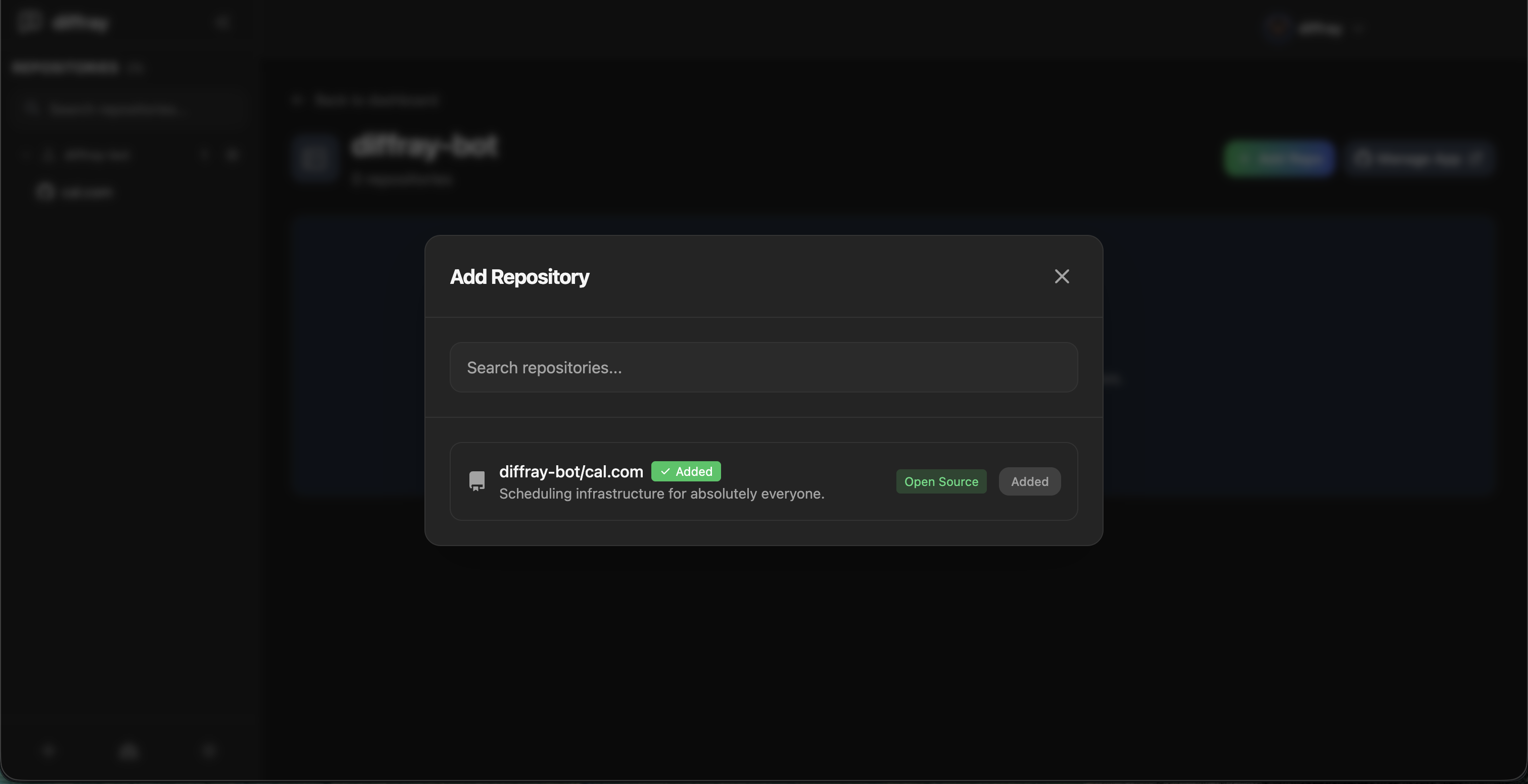

Настройте репозиторий

Настройте параметры ревью, включите нужных агентов и задайте правила команды.

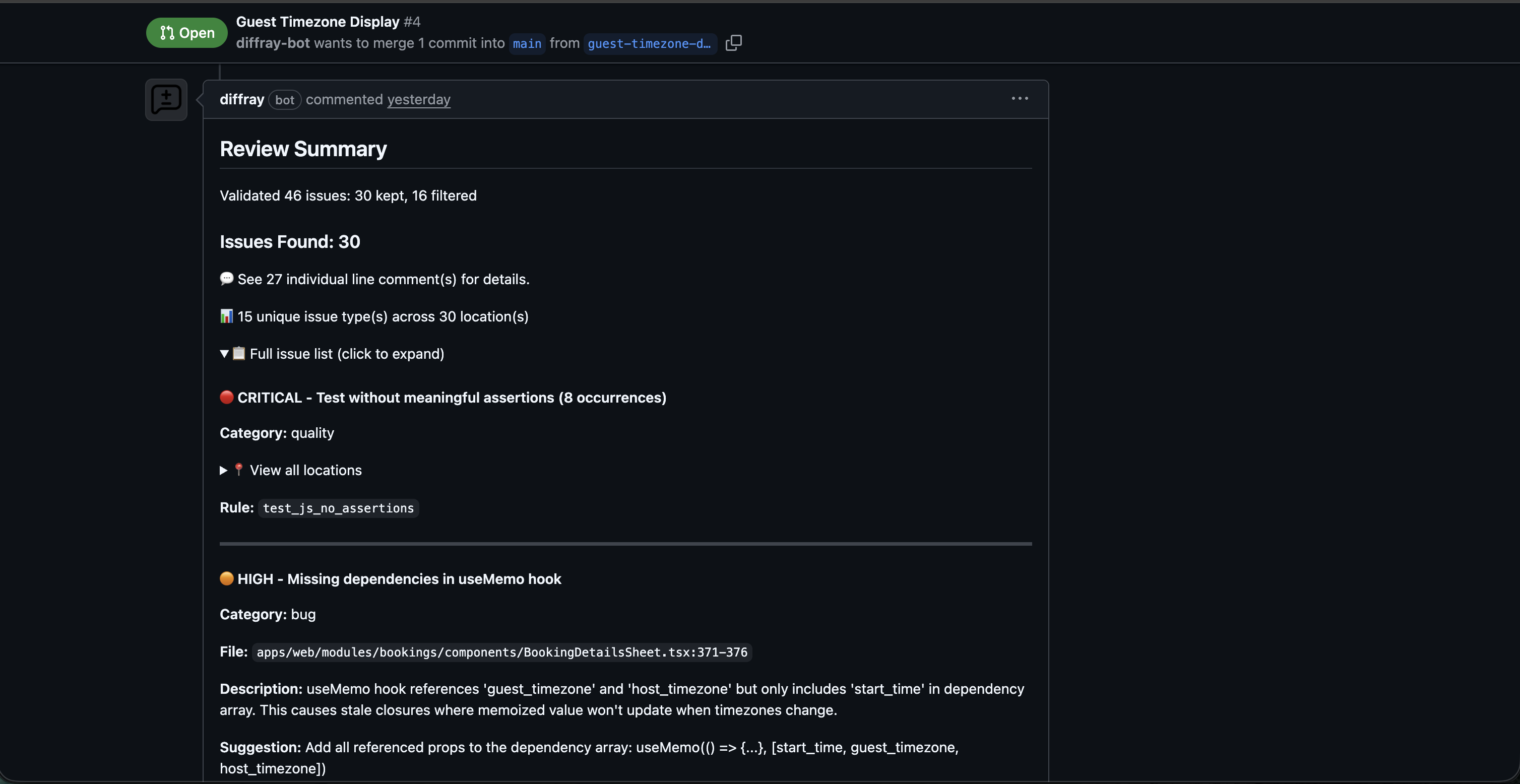

Получайте умные ревью

Откройте pull request и наблюдайте за магией. Получите целенаправленный фидбек за минуты.

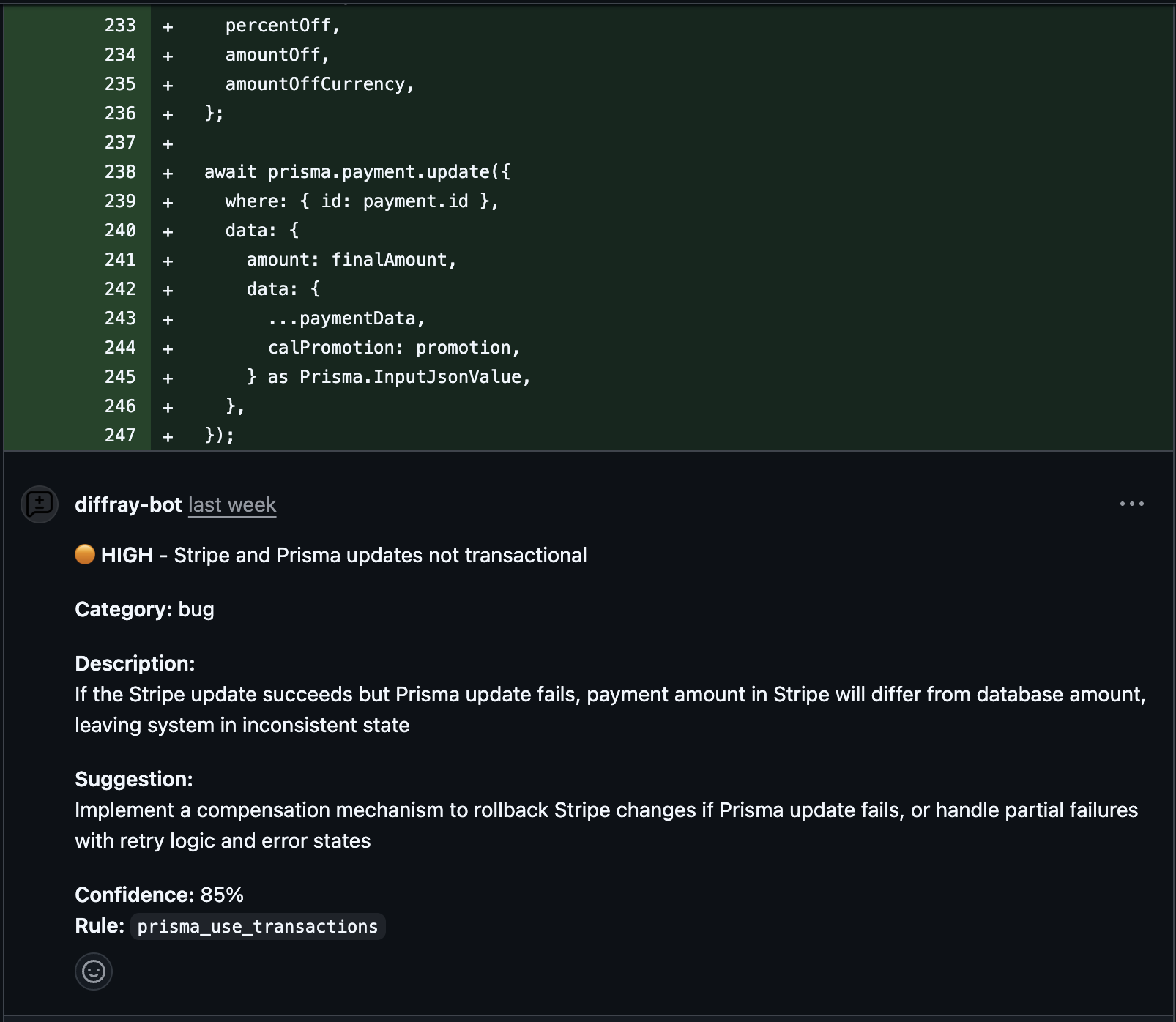

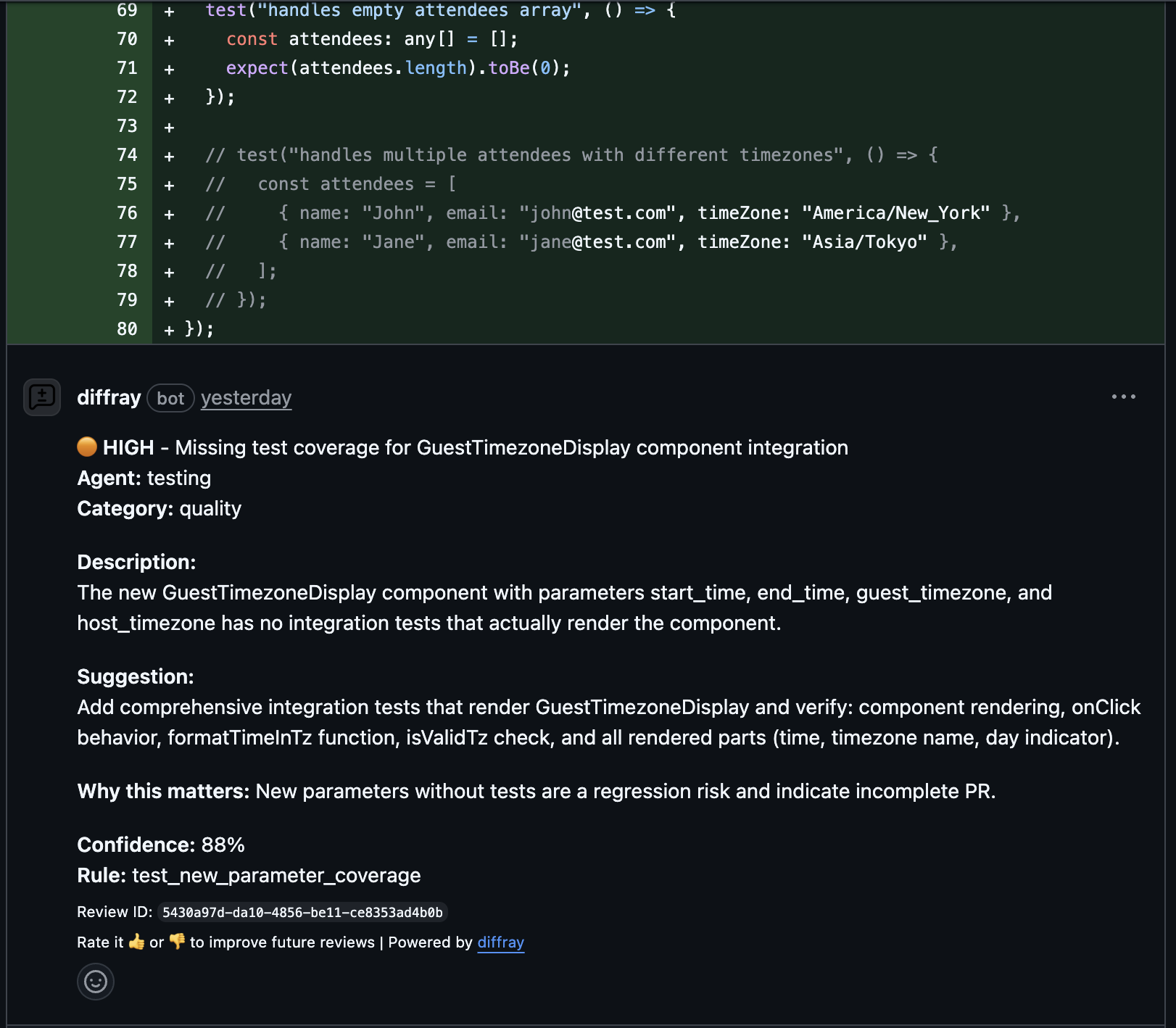

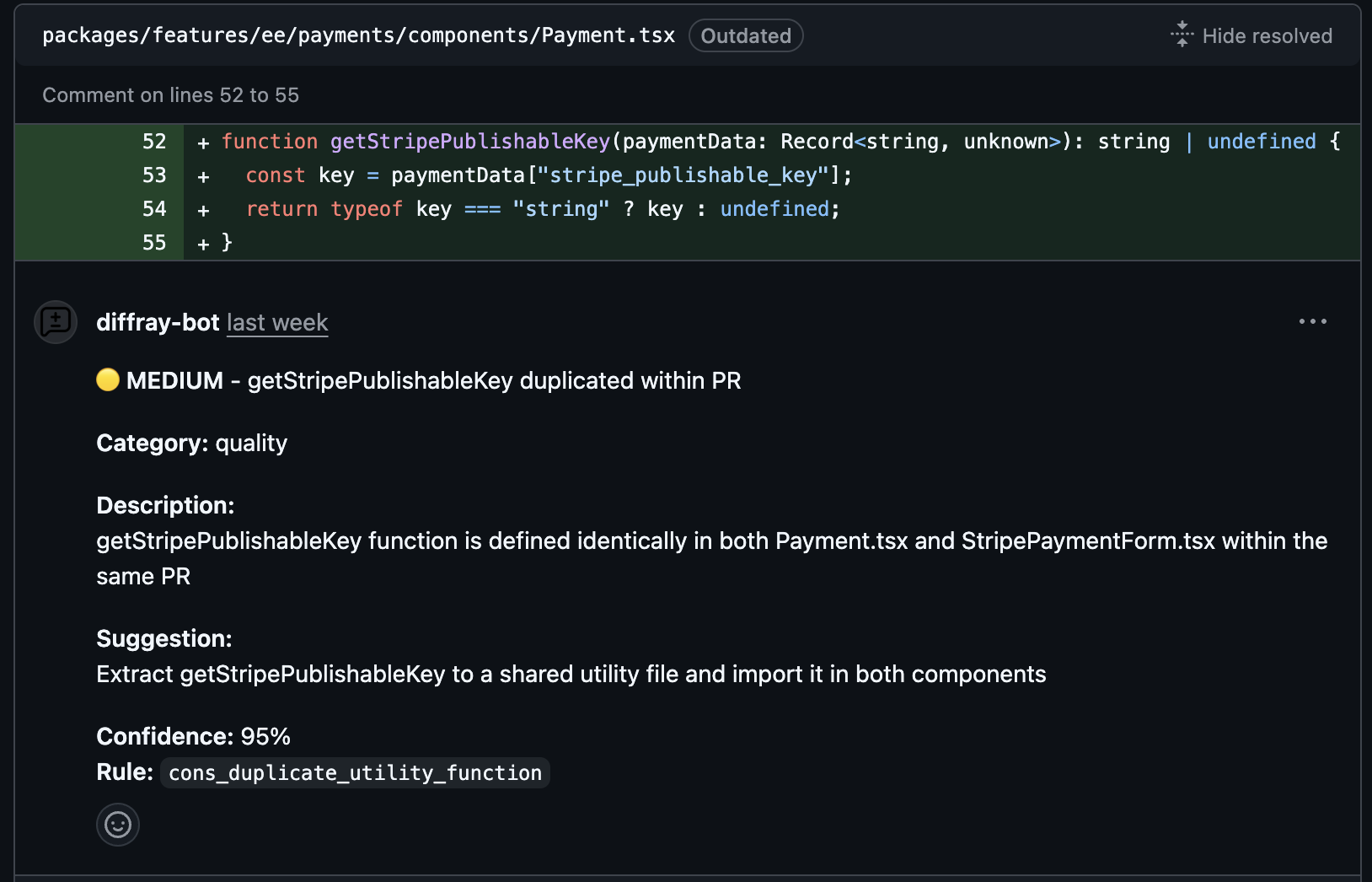

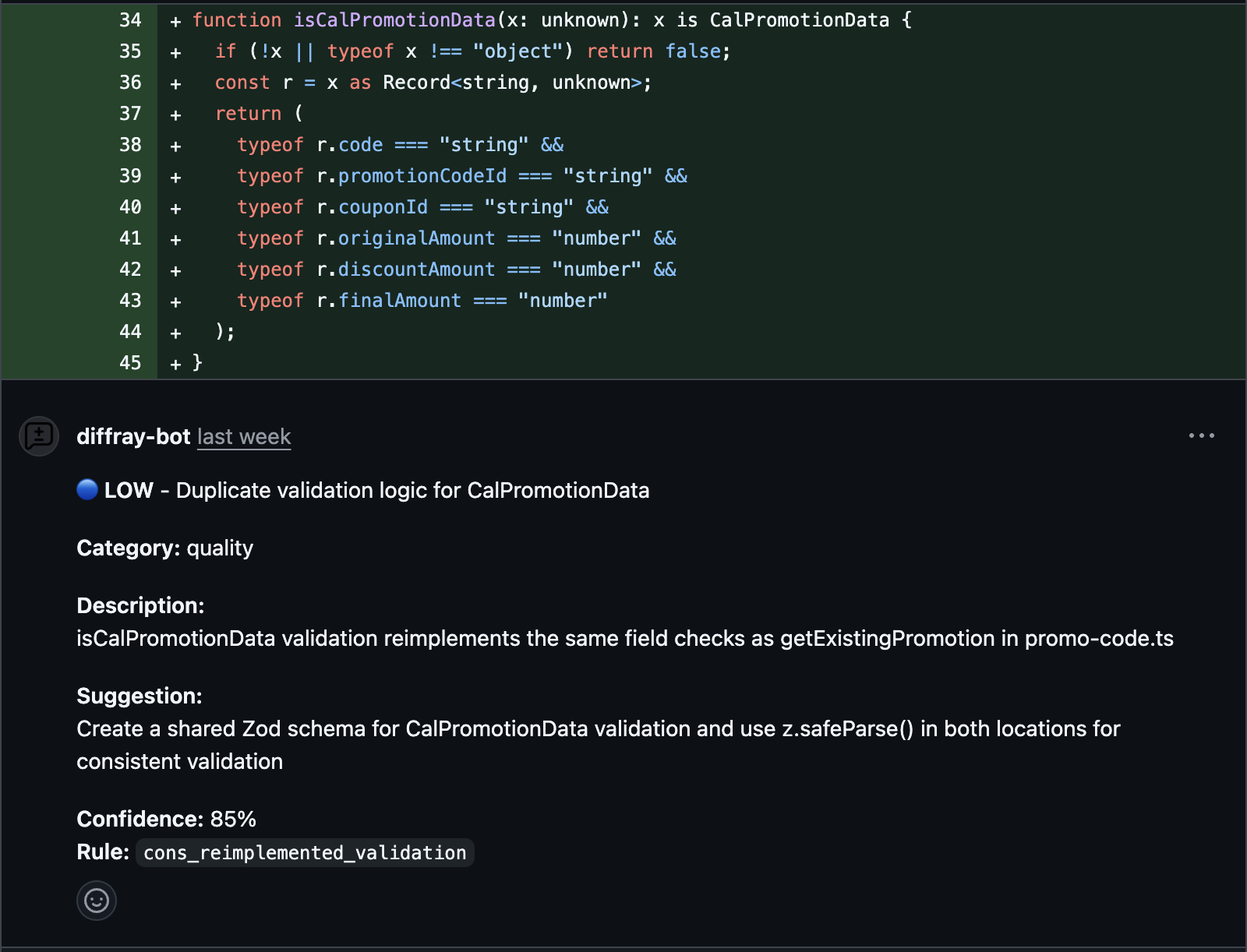

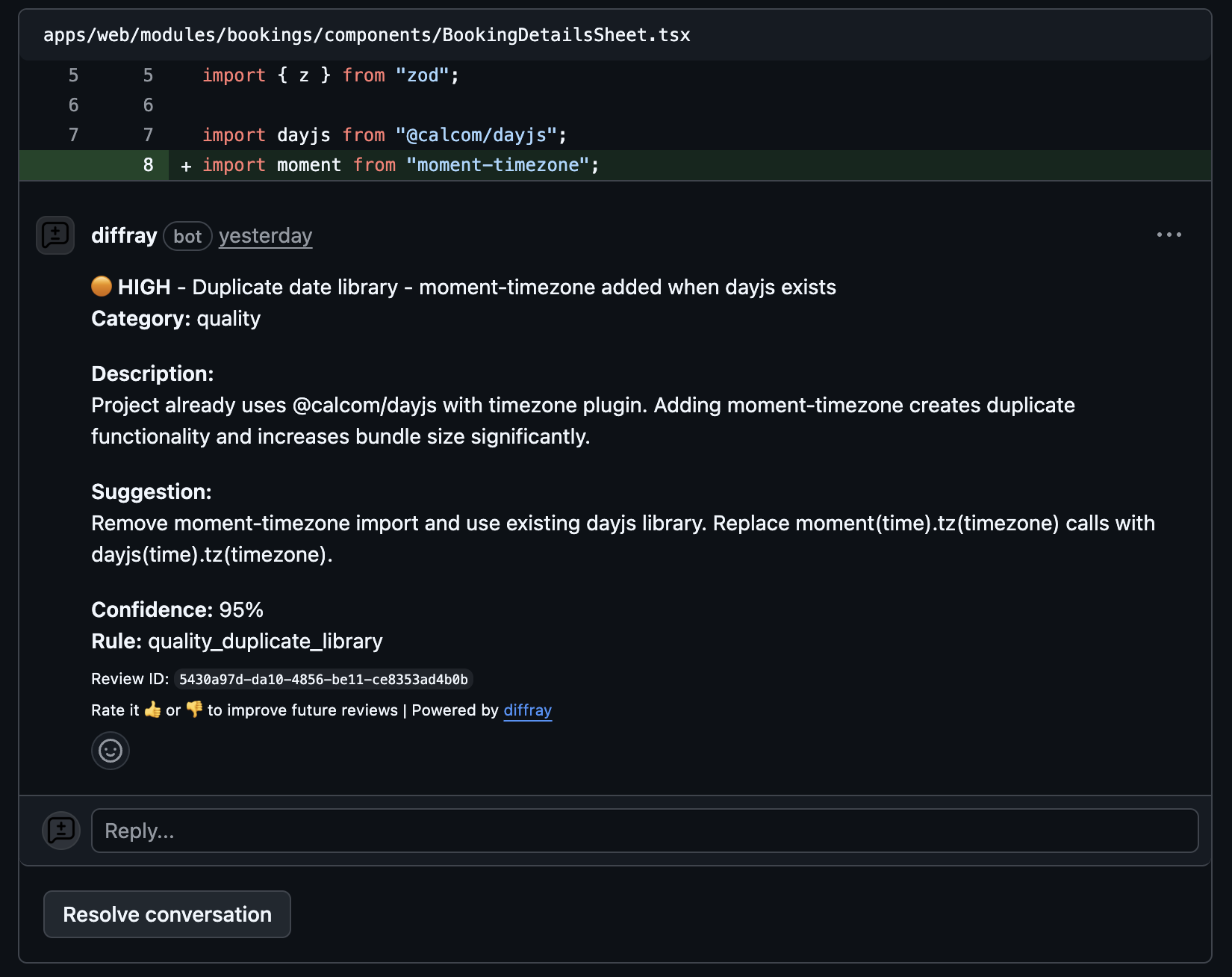

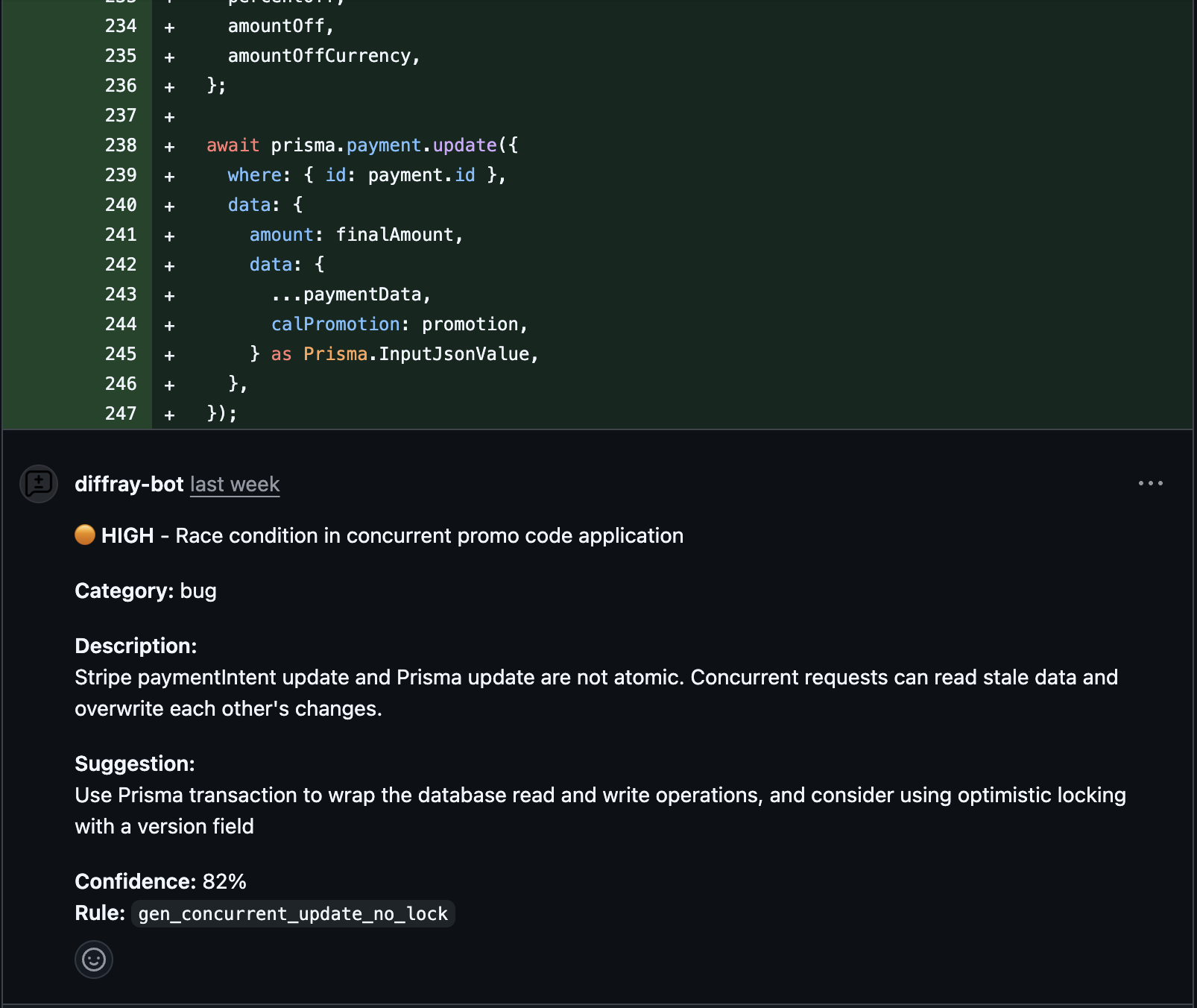

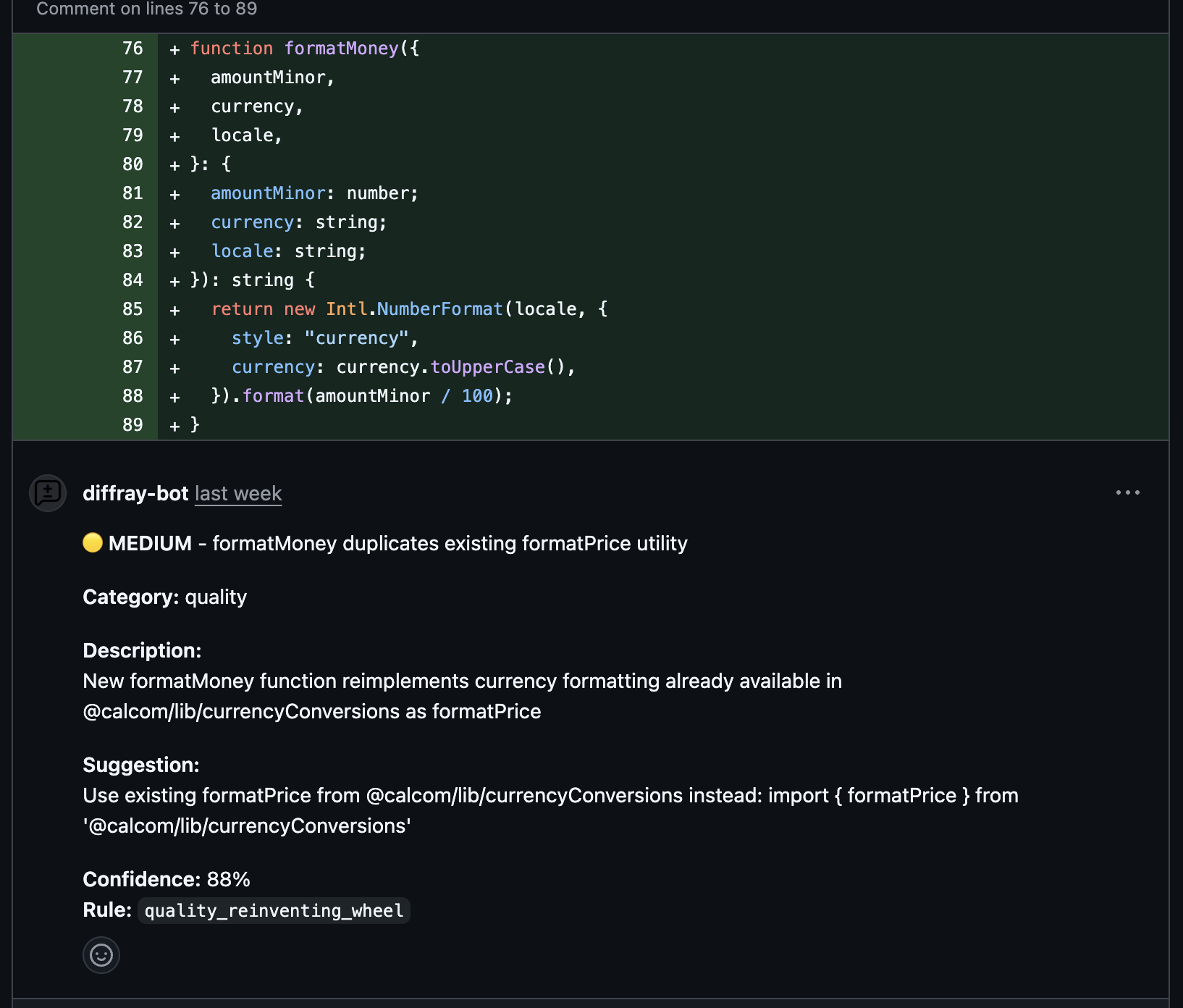

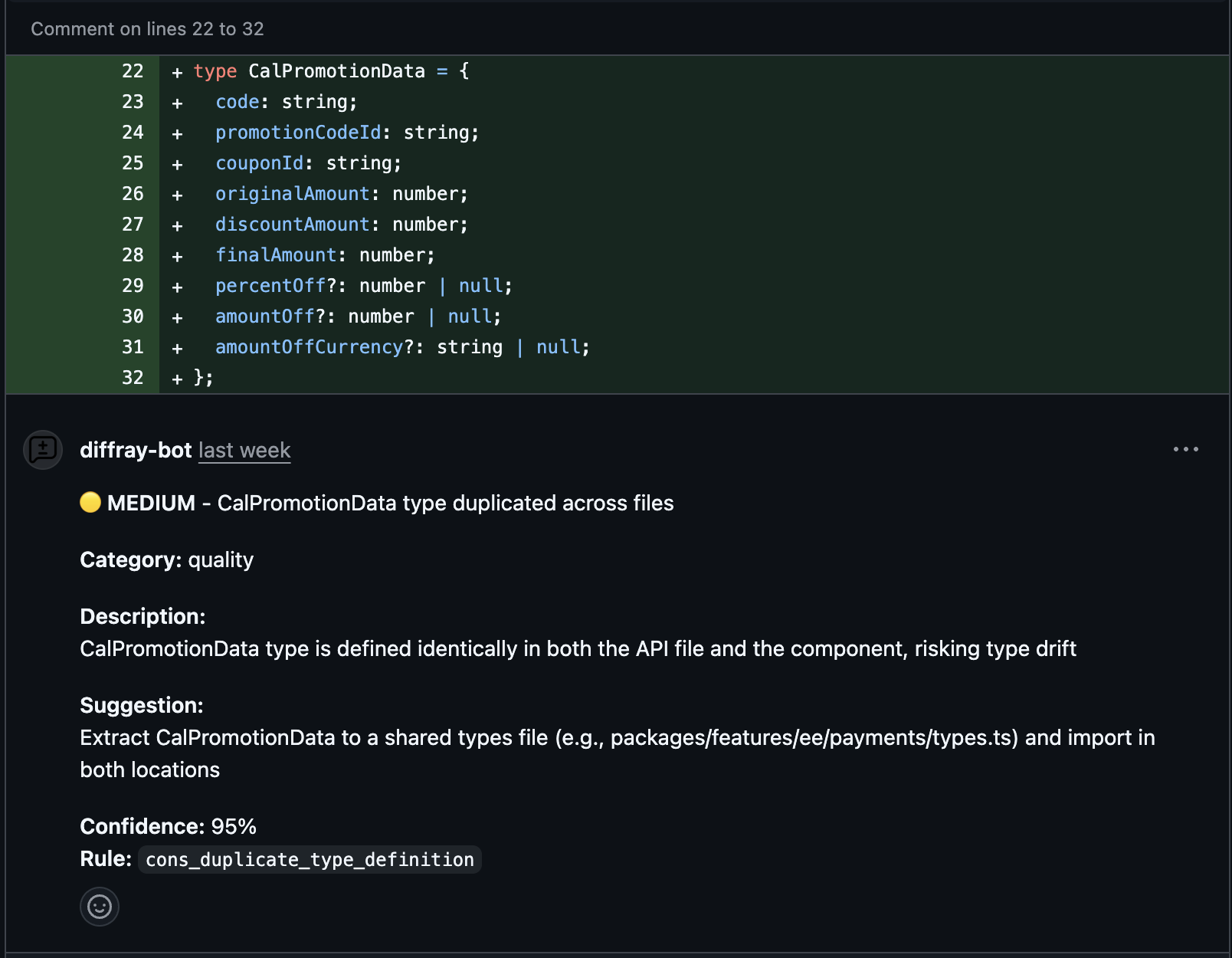

Real Issues. Real PRs.

Not mock examples — actual findings from production code reviews

Understands Your Project Context

Detected moment-timezone being added when the project already uses dayjs. A linter can't catch this — it requires understanding the existing codebase.

Finds Concurrency Issues

Concurrent requests can read stale data and overwrite each other. Suggests Prisma transactions with optimistic locking.

Finds Duplicate Utilities

New formatMoney function duplicates existing formatPrice utility. Suggests reusing what's already there.

Prevents Type Drift

CalPromotionData type defined in both API and component files. Risking type drift as code evolves.

Real findings from cal.com open-source code reviews

Как работает мульти-агентная система diffray

Несколько специализированных этапов работают вместе, чтобы найти действительно важное

PR Event

Analysis

Specialized Agents

Dedup

Review

PR Event

Context Analysis

Specialized Agents

Deduplication

Final Review

Сравнение diffray

Почему команды переходят на мульти-агентный AI

| Feature | diffray | CodeRabbit | GitHub Copilot | SonarQube |

|---|---|---|---|---|

| Цена | $9/dev/mo | $15/dev/mo | $19/user/mo | $150+/year |

| Мульти-агентный AI | ||||

| Ложные срабатывания | 87% fewer | High | High | Very High |

| Action Rate разработчиков | 98% | ~20% | ~15% | ~15% |

| Понимание кодовой базы | ||||

| Кастомные правила | ||||

| Ноль дубликатов | ||||

| Бесплатно для Open Source | Limited | Community |

Команды, которые перешли на diffray

"Мы сократили время PR-ревью с 45 до 12 минут в неделю. Команда теперь доверяет AI-фидбеку."

— Engineering Manager, SaaS-стартап 35 человек

"CodeRabbit давал нам 20+ комментариев на PR. Мы игнорировали большинство. diffray даёт 3-4, и они всегда точные."

— Техлид, финтех Series B

"Анализ с учётом кодовой базы — это прорыв. Он поймал дублирующую реализацию, которая стоила бы нам 2 дня."

— CTO, AI-стартап (20 инженеров)

Простые и прозрачные цены

Оплата за разработчика. Безлимитные ревью.

Solo

1 developer

Team

3-10 devs

Growth

11-25 devs

Scale

26-50 devs

Enterprise

50+ devs

Built on Proven Research

Our multi-agent approach is grounded in peer-reviewed research from leading institutions

"Multi-agent systems can boost visibility by up to 40% in generative engine responses through coordinated intelligence and cross-validation."

"By 2026, traditional search engine volume will decrease by 25% as AI-powered answers increasingly become the primary way users interact with information."

"Code review is the single most effective technique for finding defects, with an average effectiveness of 60% compared to 25% for unit testing alone."

Fewer false positives with multi-agent review

vs. single-agent tools

More real bugs detected

cross-validation effect

Developer action rate

vs. 15-20% industry avg

Review completion time

parallel agent processing

Хватит игнорировать AI Code Review

Попробуйте diffray бесплатно 14 дней. Без карты. Настройка за пару кликов.